Mettre à jour les modèles dans Librechat

La configuration de Librechat se fait à deux niveaux :

- Dans le fichier de configuration de Librechat

- Dans la stack (docker-compose) de Librechat

Fichier de configuration de Librechat

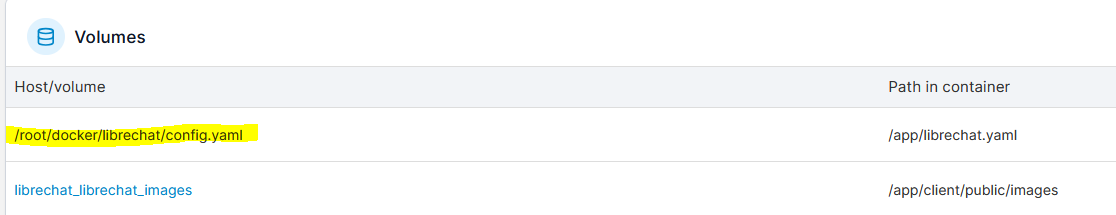

1. Identifier la localisation du fichier

Aller sur le container Librechat puis sur la partie Volumes

Le fichier peut être édité

- soit dans le container (via /app/librechat/yaml)

- soit en SSH sur le serveur (via /root/docker/librechat/config.yaml dans le cas présent)

2. Editer le fichier suivant la méthode choisie

Ci-dessous un exemple de configuration pour les modèles Ollama :

- name: "Ollama"

apiKey: "ollama"

# use 'host.docker.internal' instead of localhost if running LibreChat in a docker container

baseURL: "http://sp26.vincennes.fr:11434/v1/"

models:

default: [

"llama3.2-vision:11b","llama3.1:8b"

]

# fetching list of models is supported but the `name` field must start

# with `ollama` (case-insensitive), as it does in this example.

fetch: false

titleConvo: true

titleModel: "current_model"

summarize: false

summaryModel: "current_model"

forcePrompt: false

modelDisplayLabel: "Ollama"

La documentation de Librechat précise la signification des différents champs :

https://www.librechat.ai/docs/configuration/librechat_yaml/object_structure/custom_endpoint

Le numéro de version du fichier config doit être changé

Fichier docker-compose de Librechat

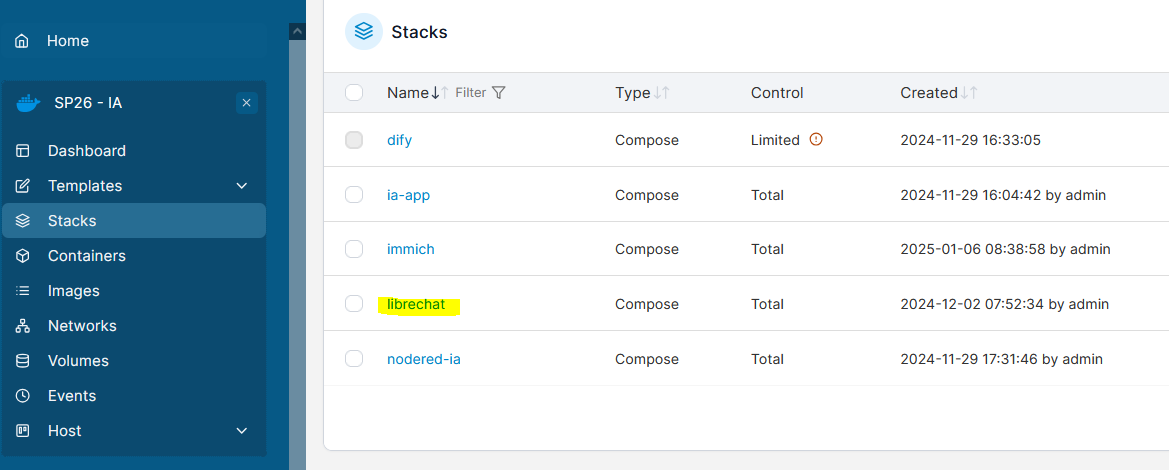

1. Dans stacks, sélectionner Librechat

2. Cliquer sur Editor

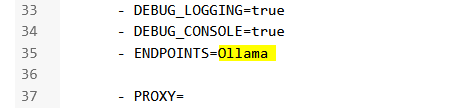

3. Modifier la variable d'environnement ENDPOINTS

Elle doit correspondre au champ "name" de config.yaml

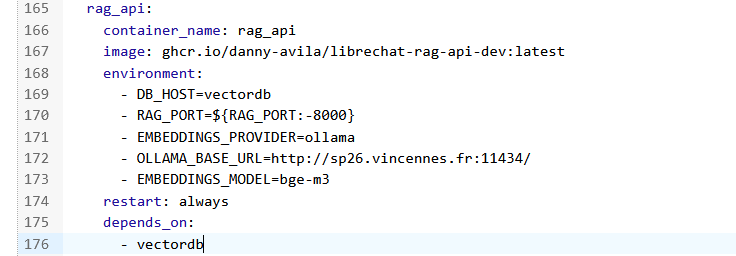

4. Embeddings

Dans le cas où le modèle d'embedding du RAG doit être modifié, les options se trouvent sur la partie "rag_api".

Les explications pour les différents champs sur dans la documentation Librechat :

https://www.librechat.ai/docs/configuration/rag_api

5. Cliquer sur Deploy pour mettre à jour Librechat

Tests

Vérifier le bon fonctionnement.

Les logs du container Librechat indiqueront les problèmes éventuels.

Pas de commentaires